【メイキング】BONUS STAGE 2020 in FUKUOKAで波動拳が撃てるようになるまで

2020.4.13

こんにちは。プログラマーの船津です。

2020年3月25日から福岡市科学館にて開催されている (※)、ストリートファイター「俺より強いやつらの世界展」において、anno labが制作した2種類の体験型コンテンツを展示しています。(※ 4月13日現在、本展示は休止中です。ご来館の際は展覧会公式ウェブサイトをご確認の上お越しください。)

――《CONTINUE? ~思い出せ!お前の負け顔~》/ created by anno lab / ©CAPCOM U.S.A., INC. ALL RIGHTS RESERVED.

――《BONUS STAGE 2020 in FUKUOKA ~撃て!お前の波動拳~》/ created by anno lab / ©CAPCOM U.S.A., INC. ALL RIGHTS RESERVED.

さて今回はこの『《BONUS STAGE 2020 in FUKUOKA ~撃て!お前の波動拳~》』で、どうやって波動拳が撃てるようになったかについて、技術面でのメイキングを簡単に紹介します。

3Dカメラ + AIでポーズを認識

『《BONUS STAGE 2020 in FUKUOKA ~撃て!お前の波動拳~》』では、体験者が波動拳のポーズをとると実際に手から波動拳が出せるのですが、ポイントは左右それぞれにあるこのカメラにあります。

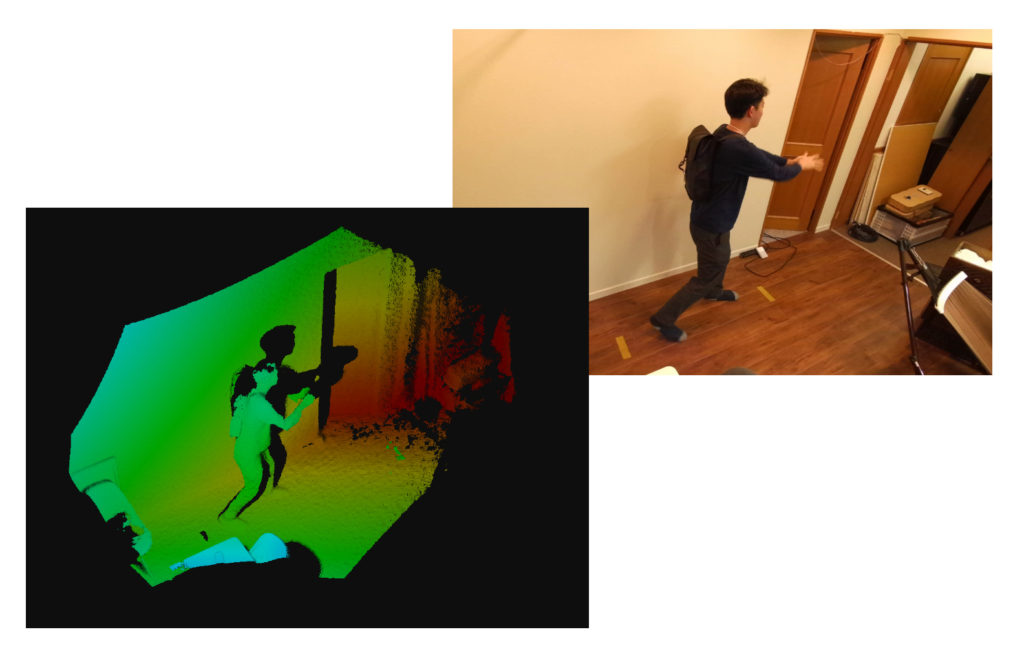

この3D深度カメラを使うと、以下のように空間を立体的にスキャンすることができます。

anno labではこうした3Dカメラを利用した体験型コンテンツをいろいろ制作してきたのですが、今回は新たな試みとして、この3DカメラにAIを組み合わせて、波動拳のポーズ(+いくつかのおまけ技)を認識できるようにAIを学習させました。

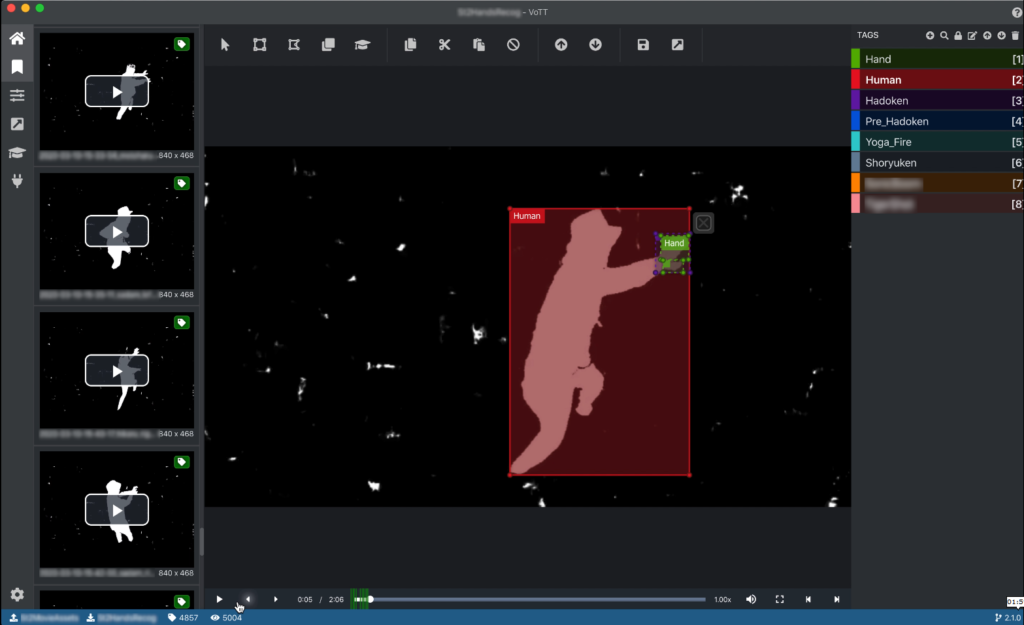

社員全員に波動拳ポーズの録画に協力してもらい、さらにCGなども含めて波動拳ポーズをたくさん収録して、だいたい5千枚くらいの画像を一つ一つ丁寧に分類してAIに学習させています。

従来であればこうした作業は、複数の技の区別をプログラマーが一つ一つ条件を入力し、細かなニュアンスについてはある程度犠牲にせざるを得ない面がありましたが、AIにポーズを学習させることで、より細かなニュアンスを区別することができるようになりました。

また、小さな子供や、スカートを着た女性など、従来の3Dカメラのみでは原理上判定が難しかったものに関しても、そうしたデータをAIに蓄積させることでより高い認識精度を得ることができるようになりました。

コンテンツ体験を、もっと自然で人間的なものに

anno labでは今までも、なきごえアートやハプニングウィンドウ などで積極的にAIの活用を進めてきましたが、こうした新たな技術を取り入れていくことによって、より体験者が自然な形で楽しめるコンテンツが実現できるようになったと感じます。

AIには様々な利用の形がありますが、anno labでは今後も、コンテンツ体験をより楽しく自然なものにできるように、こうした技術を活用していきたいと思っています。

(※ 繰り返しになりますが、4月13日現在、本展示は休止中です。ご来館の際は展覧会公式ウェブサイトをご確認の上お越しください。)

(船津)

Writer

プログラマ

Programmer

Fumiya Funatsu